Am 20. August 2025 stellte das chinesische KI-Startup DeepSeek still und leise DeepSeek V3.1 vor – ein quelloffenes, leistungsstarkes großes Sprachmodell (LLM), das es mit proprietären Giganten aufnehmen kann und gleichzeitig die Zugangsbarrieren drastisch senkt. Dieses unter der MIT-Lizenz veröffentlichte Mixture-of-Experts-Modell (MoE) bietet hybride Inferenz, umfangreiche Kontextverarbeitung und Tool-Integration auf Agentenebene. Mit DeepSeek V3.1 treten Entwickler, Forscher und Unternehmen in eine neue Ära ein, in der modernste KI kostengünstig, schnell einsetzbar und vollständig transparent ist.

Was Sie wissen müssen: DeepSeek V3.1 – Highlights

- Hybride Inferenzarchitektur: Ein einziges Modell, das sowohl einen „Denkmodus“ für tiefgreifende Schlussfolgerungen als auch einen „Nicht-Denkmodus“ für schnelle, direkte Antworten bietet.

- Spitzenleistung: Hervorragende Ergebnisse bei Codierungs-, Logik- und Mathematik-Benchmarks – übertrifft andere Open-Source-Modelle und sogar einige proprietäre Konkurrenten.

- Effizient und erschwinglich: Bis zu 68-mal günstiger als Claude Opus bei ähnlicher Leistung; die Preise sollen ab September 2025 weiter sinken.

- Vollständig Open Source unter MIT-Lizenz: Uneingeschränkte Freiheit bei der Nutzung, Anpassung, Selbsthosting und Integration.

- Entwickelt für KI-Agenten: Verbessert für Funktionsaufrufe, die Verwendung von API-Tools und die Erstellung autonomer Workflows.

Architektur und Design: Wie DeepSeek V3.1 funktioniert

Expertengemisch (MoE) Struktur

Mit insgesamt 685 Milliarden Parametern, von denen jedoch nur 37 Milliarden pro Token aktiviert sind, schafft die MoE-Architektur ein Gleichgewicht zwischen Wirkung und Recheneffizienz – sie maximiert die Wissenskapazität und minimiert gleichzeitig die Laufzeitkosten.

Massives Kontextfenster

DeepSeek V3.1 kann 128.000 Token verarbeiten und unterstützt extrem lange Kontexte, die über typische Modelle hinausgehen, sodass ganze Bücher oder Dokumente nahtlos verarbeitet werden können. Erreicht wurde dies durch einen zweistufigen Retraining-Ansatz: eine 630-Milliarden-Token-32K-Erweiterung und eine 209-Milliarden-Token-128K-Erweiterung, optimiert mit effizienten Formaten wie FP8 und UE8M0.

Hardwareorientierte Entwicklung

DeepSeek V3 war Vorreiter bei gemischten Präzisionsformaten (BF16, FP8-Varianten) und intelligenter Lastverteilung über GPU-Cluster für effizientes Training und Inferenz zu Kosten von nur 5,576 Millionen US-Dollar auf Nvidia H800s.

Die Innovation: Hybrides Denken vs. Nicht-Denken

Diese Fähigkeit macht den Unterschied:

Denkmodus (deepseek-reasoner)

- Bietet logische Argumentationsketten und ausführliche Erklärungen.

- Ideal für komplexe Logik, Mathematik und Code-Debugging.

- Bis zu 64.000 Ausgabetoken.

- Höhere Genauigkeit, etwas langsamere Reaktionszeit.

Nicht-Denkmodus (deepseek-chat)

- Schnelle, prägnante Antworten

- Unterstützung für Funktionsaufrufe und schnelle Vervollständigung

- Bis zu 8.000 Ausgabetoken

- Optimiert für latenzempfindliche Aufgaben

Bildquelle: Deepseek

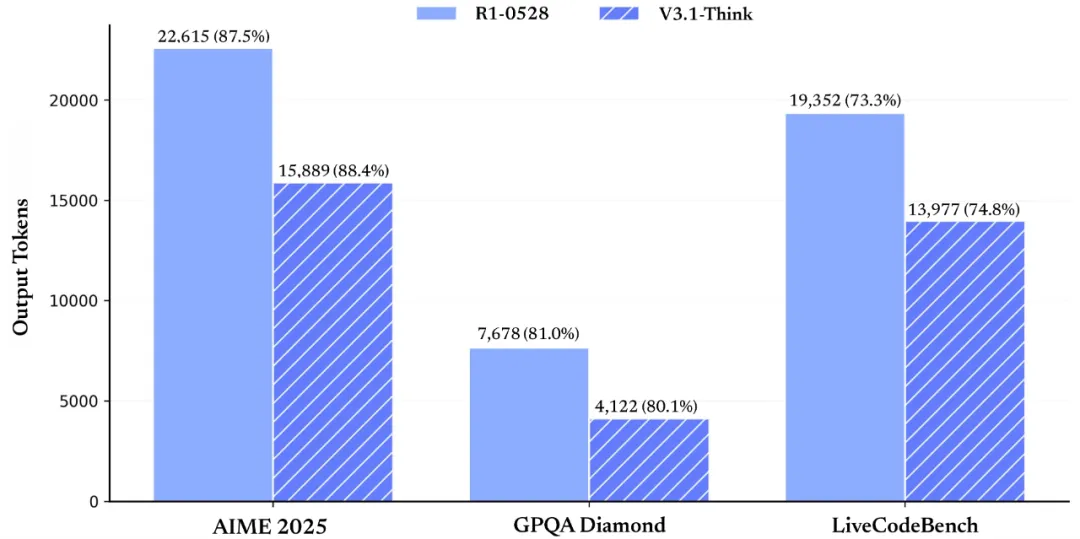

Leistungsbenchmarks: Wo DeepSeek V3.1 glänzt

DeepSeek V3.1 liefert in einer Reihe von Bewertungen Spitzenleistungen:

| Benchmark | Nicht-Denk-Punktzahl | Denkmodus-Wertung |

| HumanEval (Codierung) | 80.5% | — |

| LiveCodeBench | 56.4% | 74.8% |

| Aider-Programmierung | 68.4% | 76.3% |

| MMLU Redux (Argumentation) | 91.8% | 93.7% |

| GPQA Diamant | 74.9% | 80.1% |

| AIME 2024 (Mathematik) | 66.3% | 93.1% |

Damit liegt DeepSeek V3.1 gleichauf mit oder sogar vor DeepSeek-R1 und starken proprietären Wettbewerbern wie Claude Opus.

Zusätzliche Community-Tests zeigen einen Intelligenz- und Codierungsindex, der mit GPT-OSS-120B vergleichbar ist, wenn auch mit langsameren Generierungsgeschwindigkeiten.

KI-Agenten werden Realität: Werkzeuggebrauch und Funktionsaufruf

DeepSeek V3.1 ist strukturell für agentenbasierte Arbeitsabläufe ausgelegt:

- Funktionsaufruf im Nicht-Denkmodus für strukturierte API-Interaktion aktiviert

- Spezielle Templates für Codeagenten und Suchagenten sowie Pythonagenten, die autonome Multistep-Aufgaben ausführen. Mit diesem Fokus auf Agenten ist DeepSeek V3.1 besonders geeignet für die Entwicklung automatisierter Applikationen, welche die Recherche, den Ausführungs-Codelauf oder die Interaktion mit Drittssystemen umfassen.

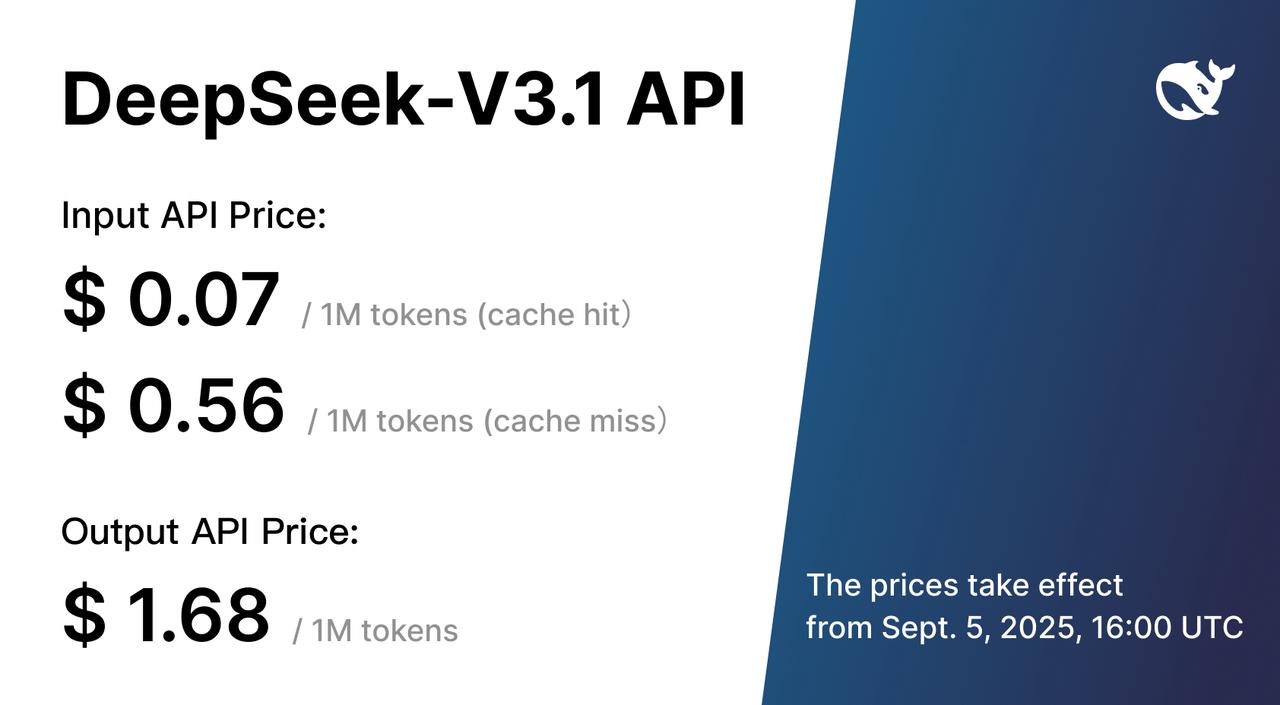

Preisgestaltung und Kosteneffizienz

DeepSeek führt eine äußerst wettbewerbsfähige Preisstruktur für den API-Zugang ein:

- 0,07 $ pro Million Eingabetoken (Cache-Treffer)

- 0,56 $ pro Million Eingabetoken (Cache-Fehler)

- 1,68 $ pro Million Ausgabetoken

DeepSeek V3.1 erreicht im Aider-Benchmark eine Erfolgsquote von 71,6 % bei Kosten von rund 1 US-Dollar pro Aufgabe, während Claude Opus ähnliche Ergebnisse für etwa 68 US-Dollar liefert.

Selbsthosting und lokale Kontrolle

Echte Open Source bedeutet, dass Sie DeepSeek V3.1 vollständig auf Ihrer eigenen Hardware ausführen können. Die Anforderungen sind beträchtlich:

- GPU-Speicher: 20,8+ GB (FP4 quantisiert)

- RAM: 500–768 GB

- Speicherplatz: 200–400 GB, abhängig von der Quantisierung

- Hardware: Nvidia H100/H200 für volle Leistung (oder RTX 3090 für Experimente)

Frameworks wie llama.cpp unterstützen hardwarespezifische Installationen und ermöglichen so vollständige lokale Kontrolle und Datenschutz.

Wie DeepSeek V3.1 im Vergleich zu Alternativen abschneidet

| Model | Lizenz | Kontext | Hybridmodi | Kosten |

| DeepSeek V3.1 | MIT (Open Source) | 128K | Ja | Niedrigster |

| GPT-4o (OpenAI) | Geschlossen | 128K | — | Hoch |

| Claude 3.5 Sonnet | Geschlossen | 200K | — | Mittel-Hoch |

| Llama 3.1 405B | Öffnen (Meta) | 128K | — | Kostenloses Selbsthosting |

DeepSeek V3.1 zeichnet sich dadurch aus, dass es die Freiheit von Open Source mit hybriden Funktionen und erstklassiger Leistung zu minimalen Kosten verbindet.

Anwendungsfälle: Wer sollte DeepSeek V3.1 verwenden?

Entwickler & Startups

- Entwickeln Sie kostengünstig agentenbasierte KI-Tools und MVPs

- Erstellen Sie Prototypen für benutzerdefinierte Chatbots mit Zugriff auf umfangreiche Dokumentationen

Unternehmen und Konzerne

- Lokale Bereitstellung für die Kontrolle sensibler Daten

- Automatisierung von Berichterstellung, Zusammenfassung und Aufgaben-Workflows

Wissenschaft & Forschung

- Reproduzierbare Forschung mit überprüfbarer Architektur

- Umfangreiches Kontextfenster für groß angelegte Analysen

Globale und mehrsprachige Teams

- Unterstützt über 50 Sprachen mit sprachübergreifender semantischer Suche

- Ideal für globale Dokumentation und mehrsprachigen Kundenservice

Auswirkungen auf die reale Geschäftswelt

Die Veröffentlichung von DeepSeek hat bereits Wellen auf den Märkten geschlagen:

- 344B+ Chinesische Chiphersteller wie Cambricon verzeichneten nach der Ankündigung der Unterstützung für DeepSeeks V3-Chips einen Kursanstieg.

- Die frühere Version R1 löste aufgrund wachsender Sorgen über preisgünstige technologische Fortschritte aus China einen Rückgang der Aktienkurse bei Nvidia sowie weiteren geeigneten US-Techunternehmen aus.

DeepSeek V3.1 ist ein weiteres Beispiel dafür, dass herkömmliche Wirtschaftsmodelle in der KI nicht zutreffend sind. Stattdessen fokussiert es sich auf Effizienz, Transparenz und Wachstum, das der Gemeinschaft zugutekommt.

Fazit: Ein neuer Open-Source-Champion entsteht

DeepSeek V3.1 ist mehr als nur ein inkrementelles Upgrade – es ist eine bahnbrechende Neuerung für Open-Source-KI. Mit hybrider Inferenz, enormer Kontextkapazität, erstklassiger Leistung, minimalen Kosten und vollständiger Zugänglichkeit unter der MIT-Lizenz schafft es neue Voraussetzungen. Ganz gleich, ob Sie autonome Agenten entwickeln, riesige Korpora verarbeiten oder Innovationen in großem Maßstab vorantreiben – DeepSeek V3.1 bietet die Raffinesse und Freiheit, die erforderlich sind, um den Einsatz von KI neu zu definieren.

Das KI-Ökosystem verändert sich: Die Macht verlagert sich zunehmend auf Entwickler, Forscher und Teams mit Visionen – und nicht nur auf diejenigen mit tiefen Taschen. DeepSeek V3.1 läutet eine Zukunft ein, in der offene, erschwingliche und leistungsstarke KI die Regel und nicht die Ausnahme ist.

FAQs

Was ist DeepSeek V3.1?

Ein Open-Source-Hybrid-Inferenz-LLM mit Denk- und Nicht-Denk-Modi, 128K-Kontext und starken Agentenfähigkeiten.

Wie unterscheidet es sich von V3-0324 oder R1?

V3.1 bietet hybride Modi, eine verbesserte Leistung (bis zu +40 %) und eine überlegene Tool-Unterstützung im Vergleich zu älteren Versionen.

Wie schneidet V3.1 im Vergleich zu GPT-5 oder Claude 4.1 ab?

Es entspricht oder übertrifft Open-Source-Modelle in Bezug auf Schlussfolgerungen und Codierung, bietet einen Hybridmodus und deutlich geringere Kosten.

Was sind typische Benchmarks?

71,6 % Aider-Code-Passrate; 93,1 % bei AIME-Mathematik; Spitzenleistung bei MMLU, GPQA.

Ist es sicher und geschützt?

Open-Source-Lösungen bieten volle Transparenz, während Selbsthosting maximale Datenhoheit garantiert – eine detaillierte Analyse folgt in der nächsten Sicherheitsstudie.